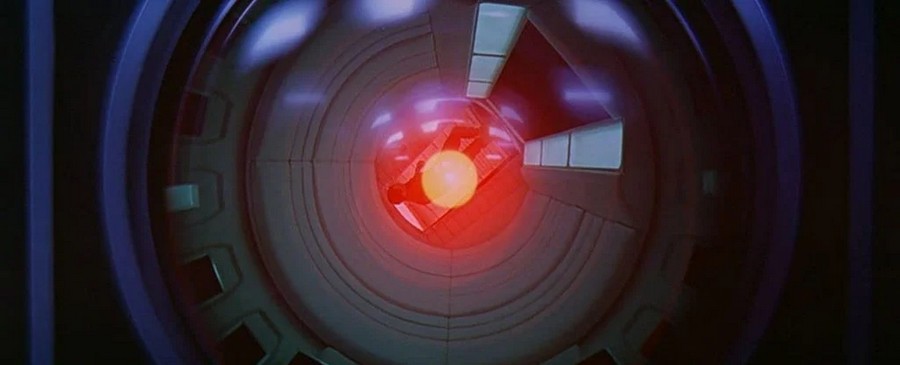

კაცობრიობის დამხობის ხელოვნური ინტელექტის იდეა ათწლეულების განმავლობაში განიხილებოდა და 2021 წლის იანვარში მეცნიერებმა გამოიტანეს განაჩენი იმის შესახებ, შეგვეძლო თუ არა მაღალი დონის კომპიუტერული სუპერინტელექტის კონტროლი. პასუხი? თითქმის რა თქმა უნდა არა.

პრობლემა ის არის, რომ სუპერგონების კონტროლი, რომელიც ადამიანური გაგების მიღმაა, მოითხოვს ამ სუპერგონების სიმულაციას, რომელიც ჩვენ შეგვიძლია გავაანალიზოთ. მაგრამ თუ ამის გაგება ვერ მოვახერხეთ, ასეთი სიმულაციის შექმნა შეუძლებელია.

2021 წლის ნაშრომის ავტორებს მიაჩნიათ, რომ ისეთი წესები, როგორიცაა „ადამიანებს ზიანი არ მიაყენო“, ვერ დადგინდება, თუ არ გვესმის, რა სცენარებს მოიტანს ხელოვნური ინტელექტი. როგორც კი კომპიუტერული სისტემა იმუშავებს იმ დონეზე, რომელიც გადააჭარბებს ჩვენი პროგრამისტების შესაძლებლობებს, ჩვენ ვეღარ შევძლებთ საზღვრების დაწესებას.

„სუპერინტელექტი ფუნდამენტურად განსხვავებული პრობლემაა, ვიდრე ჩვეულებრივ შესწავლილი „რობოტების ეთიკის“ ბანერით“, - წერენ მკვლევარები. ”ეს იმიტომ, რომ სუპერგონება მრავალმხრივია და, შესაბამისად, პოტენციურად შეუძლია სხვადასხვა რესურსების მობილიზება, რათა მიაღწიოს მიზნებს, რომლებიც პოტენციურად მიუწვდომელია ადამიანებისთვის, რომ აღარაფერი ვთქვათ კონტროლირებადი.”

გუნდის მსჯელობის ნაწილი მომდინარეობს გაჩერების პრობლემები, შემოთავაზებული ალან ტურინგის მიერ 1936 წელს. გამოწვევა არის იმის გარკვევა, მივა თუ არა კომპიუტერული პროგრამა დასკვნამდე და უპასუხებს (და გაჩერდება) თუ უბრალოდ სამუდამოდ დაკიდება ცდილობს პასუხის პოვნას.

როგორც ტურინგმა დაამტკიცა დახმარებით ინტელექტუალური მათემატიკამიუხედავად იმისა, რომ ჩვენ შეიძლება ვიცოდეთ ეს ზოგიერთი კონკრეტული პროგრამისთვის, ლოგიკურად შეუძლებელია ვიპოვოთ გზა, რომელიც მოგვცემს ამის ცოდნას ყველა პოტენციური პროგრამისთვის, რომელიც ოდესმე შეიძლებოდა დაწერილიყო. ეს გვაბრუნებს AI-ს, რომელსაც სუპერინტელექტუალურ მდგომარეობაში შეუძლია ყველა შესაძლო კომპიუტერული პროგრამის შენახვა თავის მეხსიერებაში ერთდროულად.

ასევე საინტერესოა:

- OpenAI-მ ასწავლა ხელოვნურ ინტელექტს ბრძანებების პროგრამის კოდად გადაქცევა

- ხელოვნური ინტელექტი ეძებს გრავიტაციულ ტალღებს

ნებისმიერი პროგრამა, რომელიც დაწერილია, მაგალითად, რათა შეაჩეროს ხელოვნური ინტელექტის მიყენება ადამიანებისთვის და გაანადგუროს სამყარო, შეიძლება მიაღწიოს ან არ შეწყდეს დასკვნამდე (და შეჩერდეს) - მათემატიკურად შეუძლებელია იყოს აბსოლუტურად გარკვეული, რაც ნიშნავს, რომ მისი შეკავება შეუძლებელია. „ეს ძირითადად შეკავების ალგორითმს გამოუსადეგარს ხდის“, - თქვა იანვარში გერმანიის მაქს პლანკის ადამიანური განვითარების ინსტიტუტის კომპიუტერულმა მეცნიერმა იად რაჰვანმა.

ხელოვნური ინტელექტის ეთიკისა და სამყაროს განადგურების აკრძალვების სწავლების ალტერნატივა, რაშიც არცერთი ალგორითმი არ შეიძლება იყოს აბსოლუტურად დარწმუნებული, მკვლევარების თქმით, არის სუპერგონების შესაძლებლობების შეზღუდვა. მაგალითად, ის შეიძლება მოწყდეს ინტერნეტის ნაწილს ან გარკვეულ ქსელებს.

ბოლო კვლევის ავტორები უარყოფენ ამ იდეასაც და მიაჩნიათ, რომ ის შეზღუდავს ხელოვნური ინტელექტის ფარგლებს - ამბობენ, თუ არ ვაპირებთ მის გამოყენებას ადამიანის შესაძლებლობებს მიღმა პრობლემების გადასაჭრელად, მაშინ რატომ შევქმნათ საერთოდ?

თუ ხელოვნური ინტელექტის წინსვლას ვაპირებთ, შეიძლება არც კი ვიცოდეთ, როდის გამოჩნდება სუპერინტელექტი, ჩვენი კონტროლის მიღმა, იმდენად გაუგებარია. ეს ნიშნავს, რომ ჩვენ უნდა დავიწყოთ სერიოზული კითხვების დასმა იმის შესახებ, თუ სად მივდივართ.

„სუპერინტელექტუალური მანქანა, რომელიც მართავს მსოფლიოს, ჟღერს სამეცნიერო ფანტასტიკას“, ამბობს კომპიუტერული მეცნიერი მანუელ კებრიანი მაქს პლანკის ადამიანური განვითარების ინსტიტუტიდან. მაგრამ უკვე არსებობს მანქანები, რომლებიც დამოუკიდებლად ასრულებენ რამდენიმე მნიშვნელოვან დავალებას, ხოლო პროგრამისტებს ბოლომდე არ ესმით, როგორ ისწავლეს ეს.

ამიტომ ჩნდება კითხვა, შეიძლება თუ არა ის რაღაც მომენტში გახდეს უკონტროლო და საშიში კაცობრიობისთვის...

ასევე წაიკითხეთ:

- ხელოვნურმა ინტელექტმა მოახერხა დახატული პიკასოს ნახატის რეპროდუცირება

- ხელოვნური ინტელექტი დაგეხმარებათ წინასწარ განსაზღვროთ საგზაო შემთხვევები, სანამ ისინი მოხდება